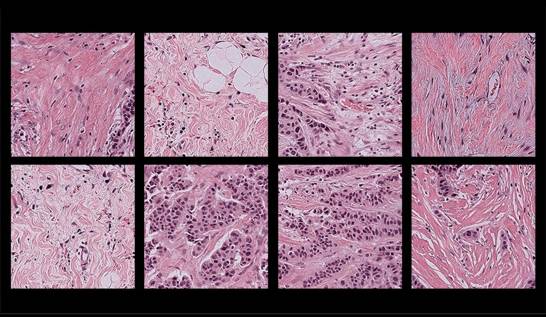

Un equipo de investigadores de la Universidad de Harvard ha desarrollado una herramienta llamada FAIR-Path que logra reducir en un 88% los sesgos de género, raza y edad presentes en los cuatro modelos de inteligencia artificial más populares para el diagnóstico de cáncer a través de análisis patológico.

El estudio, publicado en la revista Cell Reports Medicine, reveló que los modelos de IA analizados lograban inferir información demográfica de las muestras de tejido y se apoyaban en patrones poblacionales sesgados para realizar los diagnósticos, lo que resultaba en un rendimiento desigual en la detección y diferenciación de tumores.

Por ejemplo, los modelos presentaban dificultades para diferenciar subtipos de cáncer de pulmón en pacientes hombres afroamericanos, subtipos de cáncer de mama en pacientes más jóvenes, o incluso mostraban deficiencias en la detección de ciertos tipos de cáncer como el de mama, riñón, tiroides y estómago en determinados grupos.

Los investigadores atribuyen estos sesgos a diversos factores, como el entrenamiento de los modelos con tamaños de muestra desiguales por población, o a que los modelos detectan diferencias moleculares en muestras de distintos grupos demográficos y utilizan esas mutaciones como indicador, lo cual los hace menos eficaces en poblaciones donde esas mutaciones son menos frecuentes.

Para corregir estos problemas, el equipo de Harvard desarrolló FAIR-Path, una herramienta basada en aprendizaje automático contrastivo que enseña a los modelos de IA a enfatizar las diferencias entre los tipos de cáncer y restar importancia a las diferencias entre grupos poblacionales. Esto permitió reducir las deficiencias diagnósticas en torno al 88%.

"El hallazgo es alentador porque sugiere que el sesgo puede reducirse incluso sin entrenar los modelos con datos completamente justos y representativos", afirma Kun-Hsing Yu, investigador líder del estudio.

El equipo colabora ahora con instituciones de todo el mundo para estudiar el alcance del sesgo en la IA patológica en diferentes contextos demográficos y explorar formas de ampliar FAIR-Path a entornos con limitaciones de datos. El objetivo es crear modelos de IA más justos e imparciales que puedan mejorar la atención oncológica.